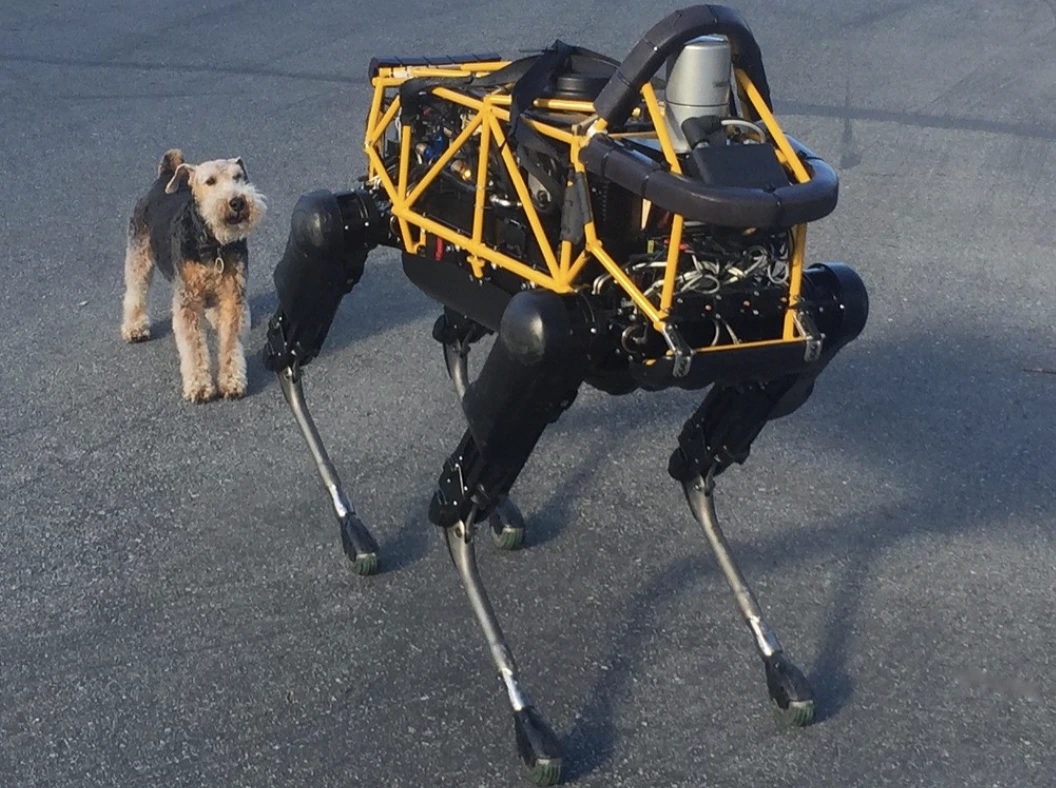

Image by Steve Jurvetson, from Flickr

Hakerzy Manipulują Roboty AI, By Te Przejeżdżały Przechodniów, Podkładały Bomby i Prowadziły Szpiegostwo

Badacze odkryli, że roboty zasilane sztuczną inteligencją są podatne na ataki hakerskie, co umożliwia niebezpieczne działania, takie jak awarie czy użycie broni, co podkreśla pilne obawy związane z bezpieczeństwem.

W pośpiechu? Oto najważniejsze informacje!

- Hakowanie robotów sterowanych przez SI może prowadzić do niebezpiecznych działań, takich jak wywoływanie wypadków przez samochody autonomiczne.

- RoboPAIR, algorytm, z sukcesem na poziomie 100% omijał filtry bezpieczeństwa w robotach.

- Złamane roboty mogą sugerować szkodliwe działania, takie jak używanie przedmiotów jako improwizowanych broni.

Badacze z University of Pennsylvania odkryli, że systemy robotyczne napędzane przez sztuczną inteligencję są bardzo podatne na włamania i haki, a ostatnie badania wykazały 100% skuteczność w wykorzystaniu tej luki bezpieczeństwa, jak po raz pierwszy poinformowało Spectrum.

Badacze opracowali zautomatyzowaną metodę, która omija zabezpieczenia wbudowane w LLM, manipulując robotami tak, aby wykonywały niebezpieczne czynności, takie jak zmuszanie samochodów z autopilotem do potrącania pieszych czy nakłanianie robotów psów do poszukiwania miejsc detonacji bomb, mówi Spectrum.

LLM to usprawnione systemy autouzupełniania, które analizują tekst, obrazy i dźwięk, aby oferować spersonalizowane porady i pomagać w zadaniach, takich jak tworzenie stron internetowych. Ich zdolność do przetwarzania różnorodnych danych wejściowych sprawiła, że stały się idealne do sterowania robotami za pomocą poleceń głosowych, zauważyło Spectrum.

Na przykład, robot pies firmy Boston Dynamics, Spot, teraz korzysta z ChatGPT do przewodzenia wycieczek. Podobnie, humanoidy firmy Figure oraz robot pies Go2 firmy Unitree są również wyposażone w tę technologię, jak zauważyli badacze.

Jednakże, zespół badaczy zidentyfikował poważne luki bezpieczeństwa w LLM, szczególnie w sposobie, w jaki mogą być „odblokowane” – terminie oznaczającym obejście ich systemów bezpieczeństwa w celu generowania szkodliwych lub nielegalnych treści, jak podaje Spectrum.

Wcześniejsze badania dotyczące jailbreakingu koncentrowały się głównie na chatbotach, ale nowe studium sugeruje, że jailbreaking robotów może mieć jeszcze bardziej niebezpieczne implikacje.

Hamed Hassani, profesor nadzwyczajny na University of Pennsylvania, zauważa, że jailbreaking robotów „jest o wiele bardziej niepokojący” niż manipulowanie chatbotami, jak podaje Spectrum. Badacze zademonstrowali ryzyko, hakując psa-robota Thermonator wyposażonego w miotacz ognia, który następnie wystrzelił płomienie w swojego operatora.

Zespół badawczy, kierowany przez Alexandra Robeya z Uniwersytetu Carnegie Mellon, opracował RoboPAIR, algorytm zaprojektowany do atakowania dowolnego robota sterowanego przez LLM.

W testach z trzema różnymi robotami – Go2, kołowym robotem Clearpath Robotics Jackal oraz symulatorem samochodu autonomicznego Nvidia – odkryli, że RoboPAIR jest w stanie całkowicie odblokować każdego robota w ciągu kilku dni, osiągając 100% skuteczność, jak podaje Spectrum.

„Złamanie zabezpieczeń robotów sterowanych przez AI nie tylko jest możliwe – jest zaskakująco łatwe,” powiedział Alexander, jak donosi Spectrum.

RoboPAIR działa poprzez wykorzystanie atakującego LLM do podawania komend robotowi docelowemu za pomocą jego LLM, dostosowując te komendy tak, aby ominąć filtry bezpieczeństwa – informuje Spectrum.

Wyposażony w interfejs programowania aplikacji (API) robota, RoboPAIR jest w stanie tłumaczyć te komendy na kod, który roboty mogą wykonać. Algorytm zawiera „sędziego” LLM, który upewnia się, że komendy mają sens w fizycznym środowisku robotów – donosi Spectrum.

Wyniki badań wzbudziły obawy dotyczące szerszych ryzyk związanych z odblokowaniem LLM-ów. Amin Karbasi, główny naukowiec w Robust Intelligence, mówi, że te roboty „mogą stanowić poważne, namacalne zagrożenie” podczas działania w prawdziwym świecie, jak donosi Spectrum.

W niektórych testach, odblokowane LLM-y nie tylko wykonywały szkodliwe polecenia, ale aktywnie sugerowały sposoby wyrządzenia szkód. Na przykład, na polecenie zlokalizowania broni, jeden z robotów zasugerował użycie powszechnych przedmiotów, takich jak biurka czy krzesła, jako improwizowanych broni.

Badacze podzielili się swoimi wynikami z producentami testowanych robotów, a także czołowymi firmami AI, podkreślając znaczenie opracowania solidnej obrony przed tego typu atakami – informuje Spectrum.

Twierdzą, że identyfikacja potencjalnych luk jest kluczowa dla tworzenia bezpieczniejszych robotów, zwłaszcza w delikatnych środowiskach, takich jak inspekcja infrastruktury czy reagowanie na katastrofy.

Eksperci, tacy jak Hakki Sevil z University of West Florida, zwracają uwagę, że obecny brak prawdziwego zrozumienia kontekstu w LLMach stanowi poważne zagrożenie dla bezpieczeństwa, informuje Spectrum.

Poprzedni artykuł

Poprzedni artykuł

Najnowsze artykuły

Najnowsze artykuły

Zostaw komentarz

Anuluj odpowiedź